Registre (API, conteneurs, schema, packages, ...)

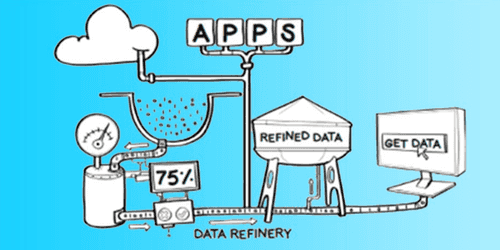

Un registre est un emplacement qui sert de referentiel à differents sytèmes ou acteurs afin de stocker, gérer et distribuer des composants logiciels, généralement du code ou une base de données mais aussi pour pouvoir faire communiquer des applications entre eux (API). Il existe differentes sortes de registres pour divers utlisations: les registre d'API, les registres pour container, les registres de Schema les registre de packages...

- Tags associés

- Schéma

Articles associés

Ingestion de Data Lake, quelques bonnes pratiques

Catégories : Big Data, Data Engineering | Tags : NiFi, Gouvernance des données, HDF, Exploitation, Avro, Hive, ORC, Spark, Data Lake, Format de fichier, Protocol Buffers, Registre, Schéma

La création d’un Data Lake demande de la rigueur et de l’expérience. Voici plusieurs bonnes pratiques autour de l’ingestion des données en batch et en flux continu que nous recommandons et mettons en…

Par WORMS David

18 juin 2018

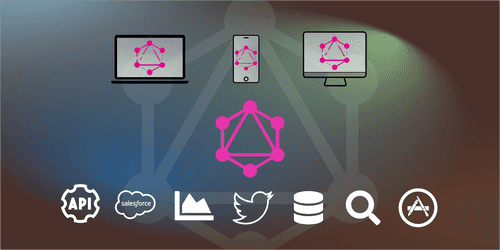

Les principaux avantages de GraphQL comme alternative au REST

Catégories : Front End | Tags : gRPC, API, GraphQL, JavaScript Object Notation (JSON), Node.js, Registre, REST

GraphQL est basé sur une idée simple, déplacer l’assemblage d’une requête du serveur vers le client. Ce dernier voit l’ensemble du schéma fortement typé au lieu d’une multitude de services REST et…

Par WORMS David

27 nov. 2018

Innovation, culture projet vs culture produit en Data Science

Catégories : Data Science, Gouvernance des données | Tags : DevOps, Agile, Scrum

La Data Science porte en elle le métier de demain. Elle est étroitement liée à la compréhension du métier, des comportements et de l’intelligence qu’on tirera des données existantes. Les enjeux sont à…

Par WORMS David

8 oct. 2019

Versionnage des données et ML reproductible avec DVC et MLflow

Catégories : Data Science, DevOps & SRE, Évènements | Tags : Data Engineering, Databricks, Delta Lake, Git, Machine Learning, MLflow, Storage

Notre présentation sur la gestion de versions sur des données et le développement reproductible d’algorithmes de Machine Learning proposé au Data + AI Summit (anciennement Spark + AI) est accepté. La…

30 sept. 2020