Data Hub

Un Data Hub est une plateforme logique qui permet l'échange de données entre les producteurs de données et les consommateurs de données comme des applications, des processus et des individus.

Il centralise les données essentielles des entreprise pour toutes les applications et permet un partage transparent des données entre les différents systèmes de stockage, tout en étant le point de vérité unique pour l'initiative de gouvernance des données. Un Data Hub diffère du Data Lake en ce que ce système prend en charge des fonctions telles que la découverte, l'indexation et l'analyse.

Articles associés

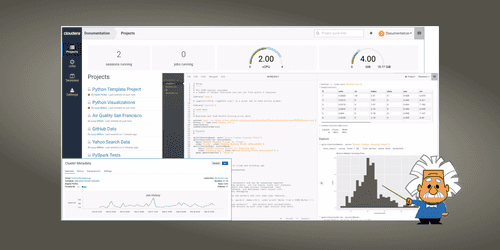

Introduction à Cloudera Data Science Workbench

Catégories : Data Science | Tags : Azure, Cloudera, Docker, Git, Kubernetes, Machine Learning, MLOps, Notebook

Cloudera Data Science Workbench est une plateforme qui permet aux Data Scientists de créer, gérer, exécuter et planifier des workflows de Data Science à partir de leur navigateur. Cela leur permet…

Par ELALAMI Mehdi

28 févr. 2019

Migration Big Data et Data Lake vers le Cloud

Catégories : Big Data, Cloud computing | Tags : DevOps, AWS, Azure, Cloud, CDP, Databricks, GCP

Est-il impératif de suivre tendance et de migrer ses données, workflow et infrastructure vers l’un des Cloud providers tels que GCP, AWS ou Azure ? Lors de la Strata Data Conference à New-York, un…

Par RUMMENS Joris

9 déc. 2019

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : Azure, Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse)

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Gestion des versions de vos jeux de données avec Data Version Control (DVC) et Git

Catégories : Data Science, DevOps & SRE | Tags : DevOps, Infrastructure, Exploitation, Git, GitOps, SCM

L’utilisation d’un système de contrôle de version tel que Git pour le code source est une bonne pratique et une norme de l’industrie. Étant donné que les projets se concentrent de plus en plus sur les…

Par JOUET Grégor

3 sept. 2020

Guide d'apprentissage pour vous former au Big Data & à L'IA avec la plateforme Databricks

Catégories : Data Engineering, Formation | Tags : Cloud, Data Lake, Databricks, Delta Lake, MLflow

Databricks Academy propose un programme de cours sur le Big Data, contenant 71 modules, que vous pouvez suivre à votre rythme et selon vos besoins. Il vous en coûtera 2000 $ US pour un accès illimité…

Par KNYAZEVA Anna

26 mai 2021

Présentation de Cloudera Data Platform (CDP)

Catégories : Big Data, Cloud computing, Data Engineering | Tags : SDX, Big Data, Cloud, Cloudera, CDP, CDH, Analyse de données, Data Hub, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une plateforme de cloud computing pour les entreprises. CDP fournit des outils intégrés et multifonctionnels en libre-service afin d’analyser et de centraliser les…

19 juil. 2021

Exigences et attentes d'une plateforme Big Data

Catégories : Big Data, Infrastructure | Tags : Data Engineering, Gouvernance des données, Analyse de données, Data Hub, Data Lake, Lakehouse, Data Science

Une plateforme Big Data est un système complexe et sophistiqué qui permet aux organisations de stocker, traiter et analyser de gros volumes de données provenant de diverses sources. Elle se compose de…

Par WORMS David

23 mars 2023