Entrepôt de données (Data Warehouse)

Un entrepôt de données est un système centralé de base de données relationnelle utilisé pour l'analyse dans l'entreprise. Il s'agit d'un référentiel de données structurées et filtrées qui ont déjà été traitées dans un but spécifique.

- En savoir plus

- Wikipédia

Articles associés

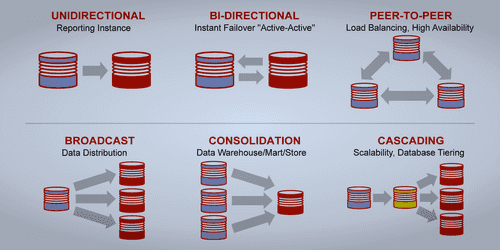

Synchronisation Oracle vers Hadoop avec un CDC

Catégories : Data Engineering | Tags : CDC, GoldenGate, Oracle, Hive, Sqoop, Entrepôt de données (Data Warehouse)

Cette note résulte d’une discussion autour de la synchronisation de données écrites dans une base de données à destination d’un entrepôt stocké dans Hadoop. Merci à Claude Daub de GFI qui la rédigea…

Par WORMS David

13 juil. 2017

Apache Hive 3, nouvelles fonctionnalités et conseils et astuces

Catégories : Big Data, Business Intelligence, DataWorks Summit 2019 | Tags : Druid, JDBC, LLAP, Hadoop, Hive, Kafka, Versions et évolutions

Disponible depuis juillet 2018 avec HDP3 (Hortonworks Data Platform 3), Apache Hive 3 apporte de nombreuses fonctionnalités intéressantes à l’entrepôt de données. Malheureusement, comme beaucoup de…

Par LEONARD Gauthier

25 juil. 2019

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : Azure, Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse)

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Snowflake, le Data Warehouse conçu pour le cloud, introduction et premiers pas

Catégories : Business Intelligence, Cloud computing | Tags : Cloud, Data Lake, Data Science, Entrepôt de données (Data Warehouse), Snowflake

Snowflake est une plateforme d’entrepôt de données en mode SaaS qui centralise, dans le cloud, le stockage et le traitement de données structurées et semi-structurées. La génération croissante de…

7 avr. 2020

Téléchargement de jeux de données dans HDFS et Hive

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data Engineering, Data structures, Base de données, Hadoop, HDFS, Hive, Big Data, Analyse de données, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Introduction De nos jours, l’analyse de larges quantités de données devient de plus en plus possible grâce aux technologies du Big data (Hadoop, Spark,…). Cela explique l’explosion du volume de…

Par NGOM Aida

31 juil. 2020

Espace de stockage et temps de génération des formats de fichiers

Catégories : Data Engineering, Data Science | Tags : Avro, HDFS, Hive, ORC, Parquet, Big Data, Data Lake, Format de fichier, JavaScript Object Notation (JSON)

Le choix d’un format de fichier appropri�é est essentiel, que les données soient en transit ou soient stockées. Chaque format de fichier a ses avantages et ses inconvénients. Nous les avons couverts…

Par NGOM Barthelemy

22 mars 2021

Guide d'apprentissage pour vous former au Big Data & à L'IA avec la plateforme Databricks

Catégories : Data Engineering, Formation | Tags : Cloud, Data Lake, Databricks, Delta Lake, MLflow

Databricks Academy propose un programme de cours sur le Big Data, contenant 71 modules, que vous pouvez suivre à votre rythme et selon vos besoins. Il vous en coûtera 2000 $ US pour un accès illimité…

Par KNYAZEVA Anna

26 mai 2021

Présentation de Cloudera Data Platform (CDP)

Catégories : Big Data, Cloud computing, Data Engineering | Tags : SDX, Big Data, Cloud, Cloudera, CDP, CDH, Analyse de données, Data Hub, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une plateforme de cloud computing pour les entreprises. CDP fournit des outils intégrés et multifonctionnels en libre-service afin d’analyser et de centraliser les…

19 juil. 2021

Utilisation de Cloudera Deploy pour installer Cloudera Data Platform (CDP) Private Cloud

Catégories : Big Data, Cloud computing | Tags : Ansible, Cloudera, CDP, Cluster, Entrepôt de données (Data Warehouse), Vagrant, IaC

Suite à notre récente présentation de CDP, passons désormais au déploiement CDP private Cloud sur votre infrastructure locale. Le deploiement est entièrement automatisé avec les cookbooks Ansible…

23 juil. 2021

Comparaison des architectures de base de données : data warehouse, data lake and data lakehouse

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, Infrastructure, Iceberg, Parquet, Spark, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Format de fichier

Les architectures de base de données ont fait l’objet d’une innovation constante, évoluant avec l’apparition de nouveaux cas d’utilisation, de contraintes techniques et d’exigences. Parmi les trois…

17 mai 2022

CDP partie 1 : introduction à l'architecture Data Lakehouse avec CDP

Catégories : Cloud computing, Data Engineering, Infrastructure | Tags : Data Engineering, Iceberg, AWS, Azure, Big Data, Cloud, Cloudera, CDP, Cloudera Manager, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une data platform hybride pour l’intégration de donnée, le machine learning et l’analyse de la data. Dans cette série d’articles nous allons décrire comment installer…

Par BAUM Stephan

8 juin 2023

CDP partie 5 : gestion des permissions utilisateurs sur CDP

Catégories : Big Data, Cloud computing, Gouvernance des données | Tags : Ranger, Cloudera, CDP, Entrepôt de données (Data Warehouse)

Lorsqu’un utilisateur ou un groupe est créé dans CDP, des permissions doivent leur être attribuées pour accéder aux ressources et utiliser les Data Services. Cet article est le cinquième d’une série…

Par CHAVARRIA Tobias

18 juil. 2023

CDP partie 6 : cas d'usage bout en bout d'un Data Lakehouse avec CDP

Catégories : Big Data, Data Engineering, Formation | Tags : NiFi, Business Intelligence, Data Engineering, Iceberg, Spark, Big Data, Cloudera, CDP, Analyse de données, Data Lake, Entrepôt de données (Data Warehouse)

Dans cet exercice pratique, nous montrons comment construire une solution big data complète avec la Cloudera Data Platform (CDP) Public Cloud, en se basant sur l’infrastructure qui a été déployée tout…

Par CHAVARRIA Tobias

24 juil. 2023

Introduction à OpenLineage

Catégories : Big Data, Gouvernance des données, Infrastructure | Tags : Data Engineering, Infrastructure, Atlas, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Traçabilité (data lineage)

OpenLineage est une spécification open source de lineage des données. La spécification est complétée par Marquez, son implémentation de référence. Depuis son lancement fin 2020, OpenLineage est…

19 févr. 2024