Python

Python est un langage de programmation dynamique, interpré et scripté. Il a été développé au début des années 1990 par Guido van Rossum. Aujourd'hui, ce langage est développé en tant que projet open-source par de nombreux développeurs dans le monde entier, dirigé par Guido via la Python Software Foundation (PSF). L'objectif du langage est de développer un langage de programmation facile à apprendre, produisant un code intuitif et lisible, tout en restant aussi puissant que les autres langages de programmation établis.

Articles associés

Lancement du site Internet de TDP

Catégories : Big Data | Tags : Programmation, Ansible, Hadoop, Python, TDP

Le nouveau site Internet de TDP (Trunk Data Platform) est en ligne. Nous vous invitons à le parcourir pour découvrir la platorme, rester informés, et cultiver le contact avec la communauté TDP. TDP…

Par WORMS David

3 oct. 2023

Plongée dans tdp-lib, le SDK en charge de la gestion de clusters TDP

Catégories : Big Data, Infrastructure | Tags : Programmation, Ansible, Hadoop, Python, TDP

Tous les déploiements TDP sont automatisés. Ansible y joue un rôle central. Avec la complexité grandissante de notre base logicielle, un nouveau système était nécessaire afin de s’affranchir des…

Par BOUTRY Guillaume

24 janv. 2023

Intégration de Spark et Hadoop dans Jupyter

Catégories : Adaltas Summit 2021, Infrastructure, Tech Radar | Tags : Infrastructure, Jupyter, Spark, YARN, CDP, HDP, Notebook, TDP

Depuis quelques années, Jupyter notebook s’impose comme la principale solution de notebook dans l’univers Python. Historiquement, Jupyter est l’outil de prédilection des data scientists développant…

Par COINTEPAS Aargan

1 sept. 2022

Variables Ansible : choisir l'emplacement approprié

Catégories : DevOps & SRE | Tags : Infrastructure, Ansible, IaC, YAML

Définir des variables pour vos playbooks et rôles Ansible peut devenir un défi à mesure que votre projet se développe. Naviguer la documentation Ansible est source de questionnements et de confusion…

Par HERMAND Xavier

15 mars 2022

H2O en pratique : un protocole combinant AutoML et les approches de modélisation traditionnelles

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python, XGBoost

H20 est livré avec de nombreuses fonctionnalités. La deuxième partie de la série H2O en pratique propose un protocole pour combiner la modélisation AutoML avec des approches de modélisation et d…

12 nov. 2021

H2O en pratique: retour d'expérience d'un Data Scientist

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

Les plates-formes d’apprentissage automatique (AutoML) gagnent en popularité et deviennent un outil puissant à disposition des data scientists. Il y a quelques mois, j’ai présenté H2O, une plate-forme…

29 sept. 2021

Python moderne, partie 3 : établir une chaîne de CI et publier son package sur PiPy

Catégories : DevOps & SRE | Tags : GitHub, CI/CD, Git, Python, Versions et évolutions, Tests unitaires

Avant de partager un package Python avec la communauté ou au sein de son organization, il est recommandé d’accomplir un certain nombres de tâches. Elles ont vocation à péréniser le bon fonctionnement…

Par BRAZA Faouzi

28 juin 2021

Python moderne, partie 2 : écrire les tests unitaires & respecter les conventions Git commit

Catégories : DevOps & SRE | Tags : Git, pandas, Python, Tests unitaires

L’application de bonnes pratiques en ingénierie logicielle apporte une plus-value certaine à vos projets. Par exemple l’écriture de tests unitaires vous permet de maintenir de larges projets en vous…

Par BRAZA Faouzi

24 juin 2021

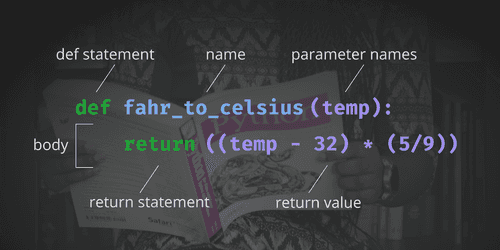

Python moderne, partie 1 : création du projet avec pyenv & poetry

Catégories : DevOps & SRE | Tags : Git, Python, Versions et évolutions, Tests unitaires

L’apprentissage d’un langage de programmation se structure souvent autour de points essentiels : pratiquer la syntaxe du langage, en maîtriser le style, comprendre certains principes et paradigmes…

Par BRAZA Faouzi

9 juin 2021

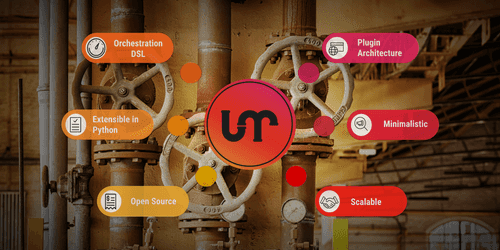

Apache Liminal, quand le MLOps rencontre le GitOps

Catégories : Big Data, Orchestration de conteneurs, Data Engineering, Data Science, Tech Radar | Tags : Data Engineering, CI/CD, Data Science, Deep Learning, Déploiement, Docker, GitOps, Kubernetes, Machine Learning, MLOps, Open source, Python, TensorFlow

Apache Liminal propose une solution clés en main permettant de déployer un pipeline de Machine Learning. C’est un projet open-source, qui centralise l’ensemble des étapes nécessaires à l’entrainement…

Par COINTEPAS Aargan

31 mars 2021

TensorFlow Extended (TFX) : les composants et leurs fonctionnalités

Catégories : Big Data, Data Engineering, Data Science, Formation | Tags : Beam, Data Engineering, Pipeline, CI/CD, Data Science, Deep Learning, Déploiement, Machine Learning, MLOps, Open source, Python, TensorFlow

La mise en production des modèles de Machine Learning (ML) et de Deep Learning (DL) est une tâche difficile. Il est reconnu qu’elle est plus sujette à l’échec et plus longue que la modélisation…

5 mars 2021

Développement accéléré de modèles avec H2O AutoML et Flow

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

La construction de modèles de Machine Learning (ML) est un processus très consommateur de temps. De plus, il requière de bonne connaissance en statistique, en algorithme de ML ainsi qu’en…

10 déc. 2020

Suivi d'expériences avec MLflow sur Databricks Community Edition

Catégories : Data Engineering, Data Science, Formation | Tags : Spark, Databricks, Deep Learning, Delta Lake, Machine Learning, MLflow, Notebook, Python, Scikit-learn

Introduction au Databricks Community Edition et MLflow Chaque jour, le nombre d’outils permettant aux Data Scientists de créer des modèles plus rapidement augmente. Par conséquent, la nécessité de…

10 sept. 2020

Importer ses données dans Databricks : tables externes et Delta Lake

Catégories : Data Engineering, Data Science, Formation | Tags : Parquet, AWS, Amazon S3, Azure Data Lake Storage (ADLS), Databricks, Delta Lake, Python

Au cours d’un projet d’apprentissage automatique (Machine Learning, ML), nous devons garder une trace des données test que nous utilisons. Cela est important à des fins d’audit et pour évaluer la…

21 mai 2020

Premier pas avec Apache Airflow sur AWS

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : PySpark, Enseignement et tutorial, Airflow, Oozie, Spark, AWS, Docker, Python

Apache Airflow offre une solution répondant au défi croissant d’un paysage de plus en plus complexe d’outils de gestion de données, de scripts et de traitements d’analyse à gérer et coordonner. C’est…

Par COINTEPAS Aargan

5 mai 2020

MLflow tutorial : une plateforme de Machine Learning (ML) Open Source

Catégories : Data Engineering, Data Science, Formation | Tags : AWS, Azure, Databricks, Deep Learning, Déploiement, Machine Learning, MLflow, MLOps, Python, Scikit-learn

Introduction et principes de MLflow Avec une puissance de calcul et un stockage de moins en moins chers et en même temps une collecte de données de plus en plus importante dans tous les domaines, de…

23 mars 2020

Optimisation d'applicationS Spark dans Hadoop YARN

Catégories : Data Engineering, Formation | Tags : Performance, Hadoop, Spark, Python

Apache Spark est un outil de traitement de données in-memory très répandu en entreprise pour traiter des problématiques Big Data. L’exécution d’une application Spark en production nécessite des…

30 mars 2020

Introduction à Ludwig et comment déployer un modèle de Deep Learning via Flask

Catégories : Data Science, Tech Radar | Tags : Enseignement et tutorial, Deep Learning, Machine Learning, Machine Learning, Python

Au cours de la dernière décennie, les modèles de Machine Learning et de Deep Learning se sont révélés très efficaces pour effectuer une grande variété de tâches tels que la détection de fraudes, la…

2 mars 2020

Spark Streaming Partie 2 : traitement d'une pipeline Spark Structured Streaming dans Hadoop

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Spark, Python, Streaming

Spark est conçu pour traiter des données streaming de manière fluide sur un cluster Hadoop multi-nœuds, utilisant HDFS pour le stockage et YARN pour l’orchestration de tâches. Ainsi, Spark Structured…

Par RYNKIEWICZ Oskar

28 mai 2019

Spark Streaming partie 3 : DevOps, outils et tests pour les applications Spark

Catégories : Big Data, Data Engineering, DevOps & SRE | Tags : Apache Spark Streaming, DevOps, Enseignement et tutorial, Spark

L’indisponibilité des services entraîne des pertes financières pour les entreprises. Les applications Spark Streaming ne sont pas exempts de pannes, comme tout autre logiciel. Une application…

Par RYNKIEWICZ Oskar

31 mai 2019

Stage Data Science & Data Engineer - ML en production et ingestion streaming

Catégories : Data Engineering, Data Science | Tags : Flink, DevOps, Hadoop, HBase, Kafka, Spark, Internship, Kubernetes, Python

Contexte L’évolution exponentielle des données a bouleversé l’industrie en redéfinissant les méthodes de stockages, de traitement et d’acheminement des données. Maitriser ces méthodes facilite…

Par WORMS David

26 nov. 2019

Mise en production d'un modèle de Machine Learning

Catégories : Big Data, Data Engineering, Data Science, DevOps & SRE | Tags : DevOps, Exploitation, IA, Cloud, Machine Learning, MLOps, On-premises, Schéma

“Le Machine Learning en entreprise nécessite une vision globale […] du point de vue de l’ingénierie et de la plateforme de données”, a expliqué Justin Norman lors de son intervention sur le…

Par RYNKIEWICZ Oskar

30 sept. 2019

Installation de TensorFlow avec Docker

Catégories : Orchestration de conteneurs, Data Science, Formation | Tags : CPU, Jupyter, Linux, IA, Deep Learning, Docker, TensorFlow

TensorFlow est un logiciel open source de Google pour le calcul numérique utilisant une représentation en graph : Vertex (nodes) représentent des opérations mathématiques Edges représentent un tableau…

Par SAUVAGE Pierre

5 août 2019

Auto-scaling de Druid avec Kubernetes

Catégories : Big Data, Business Intelligence, Orchestration de conteneurs | Tags : EC2, Druid, CNCF, Helm, Métriques, OLAP, Exploitation, Orchestration de conteneurs, Cloud, Analyse de données, Kubernetes, Prometheus, Python

Apache Druid est un système de stockage de données open-source destiné à l’analytics qui peut profiter des capacités d’auto-scaling de Kubernetes de par son architecture distribuée. Cet article est…

Par SCHOUKROUN Leo

16 juil. 2019

Apache Hive 3, nouvelles fonctionnalités et conseils et astuces

Catégories : Big Data, Business Intelligence, DataWorks Summit 2019 | Tags : Druid, JDBC, LLAP, Hadoop, Hive, Kafka, Versions et évolutions

Disponible depuis juillet 2018 avec HDP3 (Hortonworks Data Platform 3), Apache Hive 3 apporte de nombreuses fonctionnalités intéressantes à l’entrepôt de données. Malheureusement, comme beaucoup de…

Par LEONARD Gauthier

25 juil. 2019

Les fonctions de première classe en Python

Catégories : Hack, Formation | Tags : Programmation, Python

J’ai récemment regardé une conférence de Dave Cheney sur les fonctions de première classe en Go. Sachant que Python est également capable de les prendre en charge, sont-elles utilisables de la même…

Par BUSSER Arthur

15 avr. 2019

Publier Spark SQL Dataframe et RDD avec Spark Thrift Server

Catégories : Data Engineering | Tags : Thrift, JDBC, Hadoop, Hive, Spark, SQL

La nature distribuée et en-mémoire du moteur de traitement Spark en fait un excellant candidat pour exposer des données à des clients qui souhaitent des latences faibles. Les dashboards, les notebooks…

Par RYNKIEWICZ Oskar

25 mars 2019

Apprentissage par renforcement appliqué au jeu de Poker

Catégories : Data Science | Tags : Algorithme, Jeu, Q-learning, Deep Learning, Machine Learning, Réseau de neurones, Python

Dans cet article, nous présenterons le “Deep Reinforcement Learning”, et plus particulièrement l’algorithme de Deep Q Learning introduit par DeepMind il y a quelques années. Dans une seconde partie…

9 janv. 2019

Surveillance d'un cluster Hadoop de production avec Kubernetes

Catégories : DevOps & SRE | Tags : Thrift, Grafana, Shinken, Hadoop, Knox, Cluster, Docker, Elasticsearch, Kubernetes, Noeud, Node.js, Prometheus, Python

La surveillance d’un cluster Hadoop de production est un vrai challenge et se doit d’être en constante évolution. Aujourd’hui, la solution que nous utilisons se base sur Nagios. Efficace en ce qui…

21 déc. 2018

CodaLab - Concours de Data Science

Catégories : Data Science, Adaltas Summit 2018, Formation | Tags : Base de données, Infrastructure, Machine Learning, MySQL, Node.js, Python

CodaLab Competition est une plateforme servant à l’exécution de code dans le domaine de la Data Science. Elle se présente sous la forme d’une interface web sur laquelle un utilisateur peut soumettre…

17 déc. 2018

Jumbo, le bootstrapper de clusters Hadoop

Catégories : Infrastructure | Tags : Ambari, Automation, REST, Ansible, Cluster, Vagrant, HDP

Présentation de Jumbo, un bootstrapper de cluster Hadoop pour les développeurs. Jumbo vous aide à déployer des environnements de développement pour les technologies Big Data. Il suffit de quelques…

Par LEONARD Gauthier

29 nov. 2018

Lando : résumé de conversation en Deep Learning

Catégories : Data Science, Formation | Tags : Micro Services, Open API, Deep Learning, Internship, Kubernetes, Réseau de neurones, Node.js

Lando : Les derniers maîtres des mots Lando est une application de résumé de réunion qui utilise les technologies de Speech To Text pour transcrire de l’audio en écrit et les technologies de Deep…

Par HATI Yliess

18 sept. 2018

TensorFlow avec Spark 2.3 : Le Meilleur des Deux Mondes

Catégories : Data Science, DataWorks Summit 2018 | Tags : Mesos, C++, CPU, GPU, Performance, Spark, YARN, JavaScript, Keras, Kubernetes, Machine Learning, Python, TensorFlow

L’intégration de Tensorflow dans Spark apporte de nombreux bénéfices et crée de nombreuses opportunités. Cet article est basé sur une conférence du DataWorks Summit 2018 à Berlin. Cette conférence…

Par HATI Yliess

29 mai 2018

Le futur de l'orchestration de workflows dans Hadoop : Oozie 5.x

Catégories : Big Data, DataWorks Summit 2018 | Tags : REST, Hadoop, Hive, Oozie, Sqoop, CDH, HDP

Au DataWorks Summit Europe 2018 de Berlin, j’ai eu l’occasion d’assister à une session sur Apache Oozie. La présentation se concentre sur les caractéristiques du prochain Oozie 5.0 et celles à venir…

Par SCHOUKROUN Leo

23 mai 2018

Apache Beam : un modèle de programmation unifié pour les pipelines de traitement de données

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Apex, Beam, Flink, Pipeline, Spark

Dans cet article, nous allons passer en revue les concepts, l’histoire et le futur d’Apache Beam, qui pourrait bien devenir le nouveau standard pour la définition des pipelines de traitement de…

Par LEONARD Gauthier

24 mai 2018

Quelles nouveautés pour Apache Spark 2.3 ?

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Arrow, PySpark, Performance, ORC, Spark, Spark MLlib, Data Science, Docker, Kubernetes, pandas, Streaming

Plongeons nous dans les nouveautés proposées par la nouvelle distribution 2.3 d’Apache Spark. Cette article est composé de recherches et d’informations issues des présentations suivantes du DataWorks…

Par BEREZOWSKI César

23 mai 2018

Executer du Python dans un workflow Oozie

Catégories : Data Engineering | Tags : REST, Oozie, Elasticsearch, Python

Les workflows Oozie permettent d’utiliser plusieurs actions pour exécuter du code, cependant il peut être délicat d’exécuter du Python, nous allons voir comment faire. J’ai récemment implémenté un…

Par BEREZOWSKI César

6 mars 2018

De Dockerfile à Ansible Containers

Catégories : Orchestration de conteneurs, DevOps & SRE, Open Source Summit Europe 2017 | Tags : Shell, Ansible, Docker, Docker Compose, YAML

Cette présentation était une introduction au format Dockerfile et à l’outil Ansible Containers puis une comparaison des deux produits. Elle fut réalisée par Tomas Tomecek, membre de l’équipe…

Par BEREZOWSKI César

25 oct. 2017

Cloudera Sessions Paris 2017

Catégories : Big Data, Évènements | Tags : EC2, Altus, CDSW, SDX, Azure, Cloudera, CDH, Data Science, PaaS

Adaltas était présent le 5 octobre aux Cloudera Sessions, la journée de présentation des nouveaux produits Cloudera. Voici un compte rendu de ce que nous avons pu voir. Note : les informations ont été…

Par BEREZOWSKI César

16 oct. 2017

Supervision de clusters HDP

Catégories : Big Data, DevOps & SRE, Infrastructure | Tags : Alert, Ambari, Métriques, Supervision, REST, HDP

Avec la croissance actuelle des technologies BigData, de plus en plus d’entreprises construisent leurs propres clusters dans l’espoir de valoriser leurs données. L’une des principales préoccupations…

Par RUMMENS Joris

5 juil. 2017

Maitrisez vos workflows avec Apache Airflow

Catégories : Big Data, Tech Radar | Tags : DevOps, Airflow, Cloud, Python

Ci-dessous une compilation de mes notes prises lors de la présentation d’Apache Airflow par Christian Trebing de chez BlueYonder. Introduction Use case : comment traiter des données arrivant…

Par BEREZOWSKI César

17 juil. 2016

Diviser des fichiers HDFS en plusieurs tables Hive

Catégories : Data Engineering | Tags : Flume, Pig, HDFS, Hive, Oozie, SQL

Je vais montrer comment scinder fichier CSV stocké dans HDFS en plusieurs tables Hive en fonction du contenu de chaque enregistrement. Le contexte est simple. Nous utilisons Flume pour collecter les…

Par WORMS David

15 sept. 2013

E-commerce cigarettes électroniques : impressions sur Prestashop

Catégories : Tech Radar | Tags : HTML, Java, Node.js

L’année dernière, il m’a fallu choisir et intégrer une solution e-commerce pour le site de vente de cigarettes électroniques CigarHit. Etant donné que ma dernière intégration d’un site e-commerce…

Par WORMS David

25 juil. 2012

Node.js intégré à la plateforme cloud Microsoft Azure

Catégories : Cloud computing, Tech Radar | Tags : Linux, Azure, Cloud, Node.js

Node est désormais un citoyen de premier ordre dans l’environnement cloud de Microsoft Azure au côté de .Net, Java et PHP. Cette intégration est la conséquence logique de l’implication de Microsoft…

Par WORMS David

11 déc. 2011

Node.js, JavaScript côté serveur

Catégories : Front End, Node.js | Tags : HTTP, Serveur, JavaScript, Node.js

En attente du prochain grand language (NBL pour Next Big Language), cela fait maintenant 3 ans que je prédis à mes clients un bel avenir au JavaScript comme langue de programmation pour les…

Par WORMS David

12 juin 2010