Apache Spark

Apache Spark est une plateforme unifiée en mémoire pour les traitements et les analyses Big Data, le streaming de données, le requêtage SQL, le Machine Learning et les traitements de graphes.

Le projet open source a gradué au sein de la Fondation Apache en 2014 et trouve ses origine à l'UC Berkeley dans l'AMP Lab. Il est depuis devenu un acteur majeur de l'écosystème Big Data comme une alternative et une évolution au MapReduce.

En raison de son architecture distribuée, Apache Spark s'exécute dans un cluster pour traiter de grandes quantités de données avec des performances élevées et en parallèle. Apache Spark traite les données en mémoire et est optimisé pour limiter l'utilisation des disques.

De nombreux utilisateurs utilisent les Spark DataFrames, qui ont été intégrés dans Scala, Python et Java depuis Spark en version 2. Spark DataFrames, comparable à R DataFrames ou Pandas DataFrames, permet d'interroger les données dans des tables. Son intégration avec le Machine Learning permet d'appliquer des modèles analytiques au Big Data avec Apache Spark. C'est pourquoi le système est souvent appelé le couteau suisse du traitement des données.

Spark s'exécute sur diverses plates-formes, y compris dans des hôtes et des clusters autonomes, dans des clusters Hadoop avec YARN et dans la plateforme Databricks.

Articles associés

EclairJS - Un peu de Spark dans les Web Apps

Catégories : Data Engineering, Front End | Tags : Spark, JavaScript, Jupyter

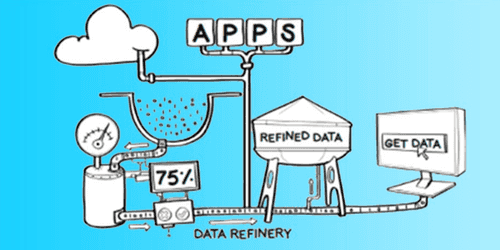

Présentation de David Fallside, IBM. Les images sont issues des slides de présentation. Introduction Le développement d’applications Web est passé d’un environnement Java vers des environnements…

Par WORMS David

17 juil. 2016

Quelles nouveautés pour Apache Spark 2.3 ?

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Arrow, PySpark, Performance, ORC, Spark, Spark MLlib, Data Science, Docker, Kubernetes, pandas, Streaming

Plongeons nous dans les nouveautés proposées par la nouvelle distribution 2.3 d’Apache Spark. Cette article est composé de recherches et d’informations issues des présentations suivantes du DataWorks…

Par BEREZOWSKI César

23 mai 2018

Apache Beam : un modèle de programmation unifié pour les pipelines de traitement de données

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Apex, Beam, Pipeline, Flink, Spark

Dans cet article, nous allons passer en revue les concepts, l’histoire et le futur d’Apache Beam, qui pourrait bien devenir le nouveau standard pour la définition des pipelines de traitement de…

Par LEONARD Gauthier

24 mai 2018

Apache Metron dans le monde réel

Catégories : Cybersécurité, DataWorks Summit 2018 | Tags : Algorithme, NiFi, Solr, Storm, pcap, SGBDR, HDFS, Kafka, Metron, Spark, Data Science, Elasticsearch, SQL

Apache Metron est une plateforme d’analyse et de stockage spécialisé dans la sécurité informatique. La conférence a été présentée par Dave Russell, ingénieur en chef des solutions - EMEA + APAC chez…

Par HATOUM Michael

29 mai 2018

TensorFlow avec Spark 2.3 : Le Meilleur des Deux Mondes

Catégories : Data Science, DataWorks Summit 2018 | Tags : Mesos, C++, CPU, GPU, Performance, Spark, YARN, JavaScript, Keras, Kubernetes, Machine Learning, Python, TensorFlow

L’intégration de Tensorflow dans Spark apporte de nombreux bénéfices et crée de nombreuses opportunités. Cet article est basé sur une conférence du DataWorks Summit 2018 à Berlin. Cette conférence…

Par HATI Yliess

29 mai 2018

Ingestion de Data Lake, quelques bonnes pratiques

Catégories : Big Data, Data Engineering | Tags : NiFi, Gouvernance des données, HDF, Exploitation, Avro, Hive, ORC, Spark, Data Lake, Format de fichier, Protocol Buffers, Registre, Schéma

La création d’un Data Lake demande de la rigueur et de l’expérience. Voici plusieurs bonnes pratiques autour de l’ingestion des données en batch et en flux continu que nous recommandons et mettons en…

Par WORMS David

18 juin 2018

Deep learning sur YARN : lancer Tensorflow et ses amis sur des clusters Hadoop

Catégories : Data Science | Tags : GPU, Hadoop, MXNet, Spark, Spark MLlib, YARN, Deep Learning, PyTorch, TensorFlow, XGBoost

Avec l’arrivée de Hadoop 3, YARN offre plus de possibilités dans la gestion des ressources. Il est désormais possible de lancer des traitements de Deep Learning sur des GPUs dans des espaces dédiés du…

Par BIANCHERIN Louis

24 juil. 2018

Migration de cluster et de traitements entre Hadoop 2 et 3

Catégories : Big Data, Infrastructure | Tags : Shiro, Erasure Coding, Rolling Upgrade, HDFS, Spark, YARN, Docker

La migration de Hadoop 2 vers Hadoop 3 est un sujet brûlant. Comment mettre à niveau vos clusters, quelles fonctionnalités présentes dans la nouvelle version peuvent résoudre les problèmes actuels et…

Par BAKALIAN Lucas

25 juil. 2018

Publier Spark SQL Dataframe et RDD avec Spark Thrift Server

Catégories : Data Engineering | Tags : Thrift, JDBC, Hadoop, Hive, Spark, SQL

La nature distribuée et en-mémoire du moteur de traitement Spark en fait un excellant candidat pour exposer des données à des clients qui souhaitent des latences faibles. Les dashboards, les notebooks…

Par RYNKIEWICZ Oskar

25 mars 2019

Mise en production d'un modèle de Machine Learning

Catégories : Big Data, Data Engineering, Data Science, DevOps & SRE | Tags : DevOps, Exploitation, IA, Cloud, Machine Learning, MLOps, On-premises, Schéma

“Le Machine Learning en entreprise nécessite une vision globale […] du point de vue de l’ingénierie et de la plateforme de données”, a expliqué Justin Norman lors de son intervention sur le…

Par RYNKIEWICZ Oskar

30 sept. 2019

Stage Data Science & Data Engineer - ML en production et ingestion streaming

Catégories : Data Engineering, Data Science | Tags : DevOps, Flink, Hadoop, HBase, Kafka, Spark, Internship, Kubernetes, Python

Contexte L’évolution exponentielle des données a bouleversé l’industrie en redéfinissant les méthodes de stockages, de traitement et d’acheminement des données. Maitriser ces méthodes facilite…

Par WORMS David

26 nov. 2019

Stage InfraOps & DevOps - construction d'une offre PaaS Big Data & Kubernetes

Catégories : Big Data, Orchestration de conteneurs | Tags : DevOps, LXD, Hadoop, Kafka, Spark, Ceph, Internship, Kubernetes, NoSQL

Contexte L’acquisition d’un cluster à forte capacité répond à la volonté d’Adaltas de construire une offre de type PAAS pour disposer et mettre à disposition des plateformes de Big Data et d…

Par WORMS David

26 nov. 2019

Hadoop Ozone partie 1: introduction du nouveau système de fichiers

Catégories : Infrastructure | Tags : HDFS, Ozone, Cluster, Kubernetes

Hadoop Ozone est système de stockage d’objet pour Hadooop. Il est conçu pour supporter des milliards d’objets de tailles diverses. Il est actuellement en développement. La feuille de route est…

3 déc. 2019

Migration Big Data et Data Lake vers le Cloud

Catégories : Big Data, Cloud computing | Tags : DevOps, AWS, Azure, Cloud, CDP, Databricks, GCP

Est-il impératif de suivre tendance et de migrer ses données, workflow et infrastructure vers l’un des Cloud providers tels que GCP, AWS ou Azure ? Lors de la Strata Data Conference à New-York, un…

Par RUMMENS Joris

9 déc. 2019

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : Azure, Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse)

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Spark Streaming partie 1 : construction de data pipelines avec Spark Structured Streaming

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Kafka, Spark, Big Data, Streaming

Spark Structured Streaming est un nouveau moteur de traitement stream introduit avec Apache Spark 2. Il est construit sur le moteur Spark SQL et utilise le modèle Spark DataFrame. Le moteur Structured…

Par RYNKIEWICZ Oskar

18 avr. 2019

Spark Streaming Partie 2 : traitement d'une pipeline Spark Structured Streaming dans Hadoop

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Spark, Python, Streaming

Spark est conçu pour traiter des données streaming de manière fluide sur un cluster Hadoop multi-nœuds, utilisant HDFS pour le stockage et YARN pour l’orchestration de tâches. Ainsi, Spark Structured…

Par RYNKIEWICZ Oskar

28 mai 2019

Spark Streaming partie 3 : DevOps, outils et tests pour les applications Spark

Catégories : Big Data, Data Engineering, DevOps & SRE | Tags : Apache Spark Streaming, DevOps, Enseignement et tutorial, Spark

L’indisponibilité des services entraîne des pertes financières pour les entreprises. Les applications Spark Streaming ne sont pas exempts de pannes, comme tout autre logiciel. Une application…

Par RYNKIEWICZ Oskar

31 mai 2019

Spark Streaming partie 4 : clustering avec Spark MLlib

Catégories : Data Engineering, Data Science, Formation | Tags : Apache Spark Streaming, Spark, Big Data, Clustering, Machine Learning, Scala, Streaming

Spark MLlib est une bibliothèque Spark d’Apache offrant des implémentations performantes de divers algorithmes d’apprentissage automatique supervisés et non supervisés. Ainsi, le framework Spark peut…

Par RYNKIEWICZ Oskar

27 juin 2019

Optimisation d'applicationS Spark dans Hadoop YARN

Catégories : Data Engineering, Formation | Tags : Performance, Hadoop, Spark, Python

Apache Spark est un outil de traitement de données in-memory très répandu en entreprise pour traiter des problématiques Big Data. L’exécution d’une application Spark en production nécessite des…

30 mars 2020

Premier pas avec Apache Airflow sur AWS

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : PySpark, Enseignement et tutorial, Airflow, Oozie, Spark, AWS, Docker, Python

Apache Airflow offre une solution répondant au défi croissant d’un paysage de plus en plus complexe d’outils de gestion de données, de scripts et de traitements d’analyse à gérer et coordonner. C’est…

Par COINTEPAS Aargan

5 mai 2020

Automatisation d'un workflow Spark sur GCP avec GitLab

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : Enseignement et tutorial, Airflow, Spark, CI/CD, GitLab, GitOps, GCP, Terraform

Un workflow consiste à automiatiser une succéssion de tâche qui dont être menée indépendemment d’une intervention humaine. C’est un concept important et populaire, s’appliquant particulièrement à un…

16 juin 2020

Comparaison de différents formats de fichier en Big Data

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data structures, Avro, HDFS, ORC, Parquet, Traitement par lots, Big Data, CSV, JavaScript Object Notation (JSON), Kubernetes, Protocol Buffers

Dans l’univers du traitement des données, il existe différents types de formats de fichiers pour stocker vos jeu de données. Chaque format a ses propres avantages et inconvénients selon les cas d…

Par NGOM Aida

23 juil. 2020

Versionnage des données et ML reproductible avec DVC et MLflow

Catégories : Data Science, DevOps & SRE, Évènements | Tags : Data Engineering, Databricks, Delta Lake, Git, Machine Learning, MLflow, Storage

Notre présentation sur la gestion de versions sur des données et le développement reproductible d’algorithmes de Machine Learning proposé au Data + AI Summit (anciennement Spark + AI) est accepté. La…

30 sept. 2020

Suivi d'expériences avec MLflow sur Databricks Community Edition

Catégories : Data Engineering, Data Science, Formation | Tags : Spark, Databricks, Deep Learning, Delta Lake, Machine Learning, MLflow, Notebook, Python, Scikit-learn

Introduction au Databricks Community Edition et MLflow Chaque jour, le nombre d’outils permettant aux Data Scientists de créer des modèles plus rapidement augmente. Par conséquent, la nécessité de…

10 sept. 2020

Construire votre distribution Big Data open source avec Hadoop, Hive, HBase, Spark et Zeppelin

Catégories : Big Data, Infrastructure | Tags : Maven, Hadoop, HBase, Hive, Spark, Git, Versions et évolutions, TDP, Tests unitaires

L’écosystème Hadoop a donné naissance à de nombreux projets populaires tels que HBase, Spark et Hive. Bien que des technologies plus récentes commme Kubernetes et les stockages objets compatibles S…

Par SCHOUKROUN Leo

18 déc. 2020

Adaltas Summit 2021, seconde édition sur l'Île de Beauté

Catégories : Adaltas Summit 2021, Formation | Tags : Ansible, Hadoop, Spark, Azure, Blockchain, Deep Learning, Docker, Terraform, Kubernetes, Node.js

Pour sa seconde édition, l’ensemble de l’équipe Adaltas se réunit en Corse pour une semaine avec 2 jours dédiés à parler tech les 23 et 24 septembre 2021. Après une année et demi de restriction…

Par WORMS David

21 sept. 2021

Stage en infrastructure Big Data avec TDP

Catégories : Infrastructure, Formation | Tags : Cybersécurité, DevOps, Java, Ansible, Hadoop, Internship, TDP

Le Big Data et l’informatique distribuée sont au cœur d’Adaltas. Nous accompagnons nos partenaires dans le déploiement, la maintenance et l’optimisation de certains des plus grands clusters de France…

Par HARTY Daniel

25 oct. 2021

Stage de fin d'étude printemps 2022 - construction d'un Data Lab

Catégories : Data Science, Formation | Tags : Spark, Argo CD, Elasticsearch, Internship, Keycloak, Kubernetes, MongoDB, OpenID Connect, PostgreSQL

Descriptif du stage Au cours des dernières années, nous avons développé la capacité d’utiliser les ordinateurs pour traiter une grande quantité de données. L’écosystème a évolué vers une offre étendue…

Par WORMS David

24 nov. 2021

Découvrez Trunk Data Platform : La Distribution Big Data Open-Source par TOSIT

Catégories : Big Data, DevOps & SRE, Infrastructure | Tags : Ranger, DevOps, Hortonworks, Ansible, Hadoop, HBase, Knox, Spark, Cloudera, CDP, CDH, Open source, TDP

Depuis la fusion de Cloudera et Hortonworks, la sélection de distributions Hadoop commerciales on-prem se réduit à CDP Private Cloud. CDP est un mélange de CDH et de HDP conservant les meilleurs…

Par SCHOUKROUN Leo

14 avr. 2022

Collecte de logs Databricks vers Azure Monitor à l'échelle d'un workspace

Catégories : Cloud computing, Data Engineering, Adaltas Summit 2021 | Tags : Métriques, Supervision, Spark, Azure, Databricks, Log4j

Databricks est une plateforme optimisée d’analyse de données, basée sur Apache Spark. La surveillance de la plateforme Databricks est cruciale pour garantir la qualité des données, les performances du…

Par PLAYE Claire

10 mai 2022

Comparaison des architectures de base de données : data warehouse, data lake and data lakehouse

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, Infrastructure, Iceberg, Parquet, Spark, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Format de fichier

Les architectures de base de données ont fait l’objet d’une innovation constante, évoluant avec l’apparition de nouveaux cas d’utilisation, de contraintes techniques et d’exigences. Parmi les trois…

17 mai 2022

Intégration de Spark et Hadoop dans Jupyter

Catégories : Adaltas Summit 2021, Infrastructure, Tech Radar | Tags : Infrastructure, Spark, YARN, CDP, HDP, Jupyter, Notebook, TDP

Depuis quelques années, Jupyter notebook s’impose comme la principale solution de notebook dans l’univers Python. Historiquement, Jupyter est l’outil de prédilection des data scientists développant…

Par COINTEPAS Aargan

1 sept. 2022

CDP partie 6 : cas d'usage bout en bout d'un Data Lakehouse avec CDP

Catégories : Big Data, Data Engineering, Formation | Tags : NiFi, Business Intelligence, Data Engineering, Iceberg, Spark, Big Data, Cloudera, CDP, Analyse de données, Data Lake, Entrepôt de données (Data Warehouse)

Dans cet exercice pratique, nous montrons comment construire une solution big data complète avec la Cloudera Data Platform (CDP) Public Cloud, en se basant sur l’infrastructure qui a été déployée tout…

Par CHAVARRIA Tobias

24 juil. 2023